Googlebot: מיתוסים, מציאות, ואיך לפצח את צופן הדירוג האורגני

דמיינו לרגע שאתם במסע חשאי לתוך ליבת העולם הדיגיטלי. אתם מתגנבים בשקט במסדרונות העצומים של מרכזי הנתונים של גוגל, עוקפים מערכות אבטחה מתוחכמות, ונחושים לחשוף את הסודות השמורים ביותר מאחורי מסך תוצאות החיפוש המוכר. אתם מגיעים לדלת האחרונה, מציצים פנימה בזהירות רבה, ואז נכנסים בזריזות. ושם, במרכז חדר מואר ומלא שרתים, אתם רואים אותו – את Googlebot, הישות הדיגיטלית המסתורית שאחראית על סריקת הרשת, הבנת התוכן, והעברת המידע לאלגוריתמים שמחליטים על גורלם של מיליארדי דפי אינטרנט בתוצאות החיפוש היומיות.

Googlebot הוא ללא ספק אחד הרכיבים הקריטיים ביותר באקוסיסטמה של קידום אתרים, ואחד המעניינים ביותר. אולם, סביב זהותו ואופן פעולתו נבנו לאורך השנים מיתוסים רבים. תפיסות שגויות אלו, גם אם נשמעות הגיוניות או מפתות, עלולות להוביל לאסטרטגיות קידום אתרים שגויות, לבזבוז משאבים, ואף לנזק של ממש. כדי להצליח באמת, עלינו לפצח את צופן המיתוסים, להבין את המציאות הטכנית והאלגוריתמית שמאחורי Googlebot, ולרתום את הידע הזה לבניית אתרים שרובוטים ומשתמשים אוהבים כאחד.

בואו נפריך כמה מהמיתוסים הנפוצים ביותר לגבי Googlebot, ונגלה איך הבנת האמת יכולה לשדרג את אסטרטגיית קידום האתרים שלכם.

פענוח ה"קופסה השחורה": 9 מיתוסים נפוצים על Googlebot והמציאות שמקדמי אתרים חייבים להכיר

-

מיתוס #1: Googlebot סורק ומאנדקס כל עמוד באתר שלכם באופן אוטומטי ובתדירות גבוהה.

- המציאות: ל-Googlebot יש מגבלות משאבים, ולכל אתר מוקצה "תקציב זחילה" (Crawl Budget) – כמות משוערת של עמודים ש-Googlebot יזחל באתר מסוים בפרק זמן נתון (לרוב ביום). תקציב זה אינו אחיד; אתרים גדולים, סמכותיים, בעלי תוכן שמתעדכן בתדירות גבוהה, ועם ביצועים טכניים טובים (מהירות טעינה, זמינות) – יקבלו תקציב זחילה גבוה יותר ותדירות סריקה גבוהה יותר. עמודים "חבויים" עמוק במבנה האתר, ללא קישורים פנימיים ברורים המצביעים עליהם, או שאינם מופיעים במפת אתר XML עדכנית – עלולים להיזחל לעיתים רחוקות, אם בכלל. כפי שגוגל עצמה מציינת, קישורים פנימיים הם קריטיים לגילוי עמודים.

- ההשלכה על קידום אתרים: עמודים חשובים שלא נזחלים או מאונדקסים – לא יופיעו בתוצאות החיפוש. תקציב זחילה מבוזבז על זחילת עמודים חסרי חשיבות (כמו דפי פרמטרים עם תוכן כפול) – פוגע ביכולת גוגל לגלות עמודים חשובים באמת.

- המסקנה האסטרטגית: בנה ארכיטקטורת אתר ברורה והיררכית. צור מבנה קישור פנימי חזק והגיוני שמנחה את Googlebot וגולשים כאחד לעמודים החשובים. ודא שמפת אתר XML שלך עדכנית, כוללת את כל העמודים הרלוונטיים, ומוגשת ל-Google Search Console (GSC). טפל בבעיות טכניות המשפיעות על Crawl Budget (שגיאות שרת, הפניות שבורות).

-

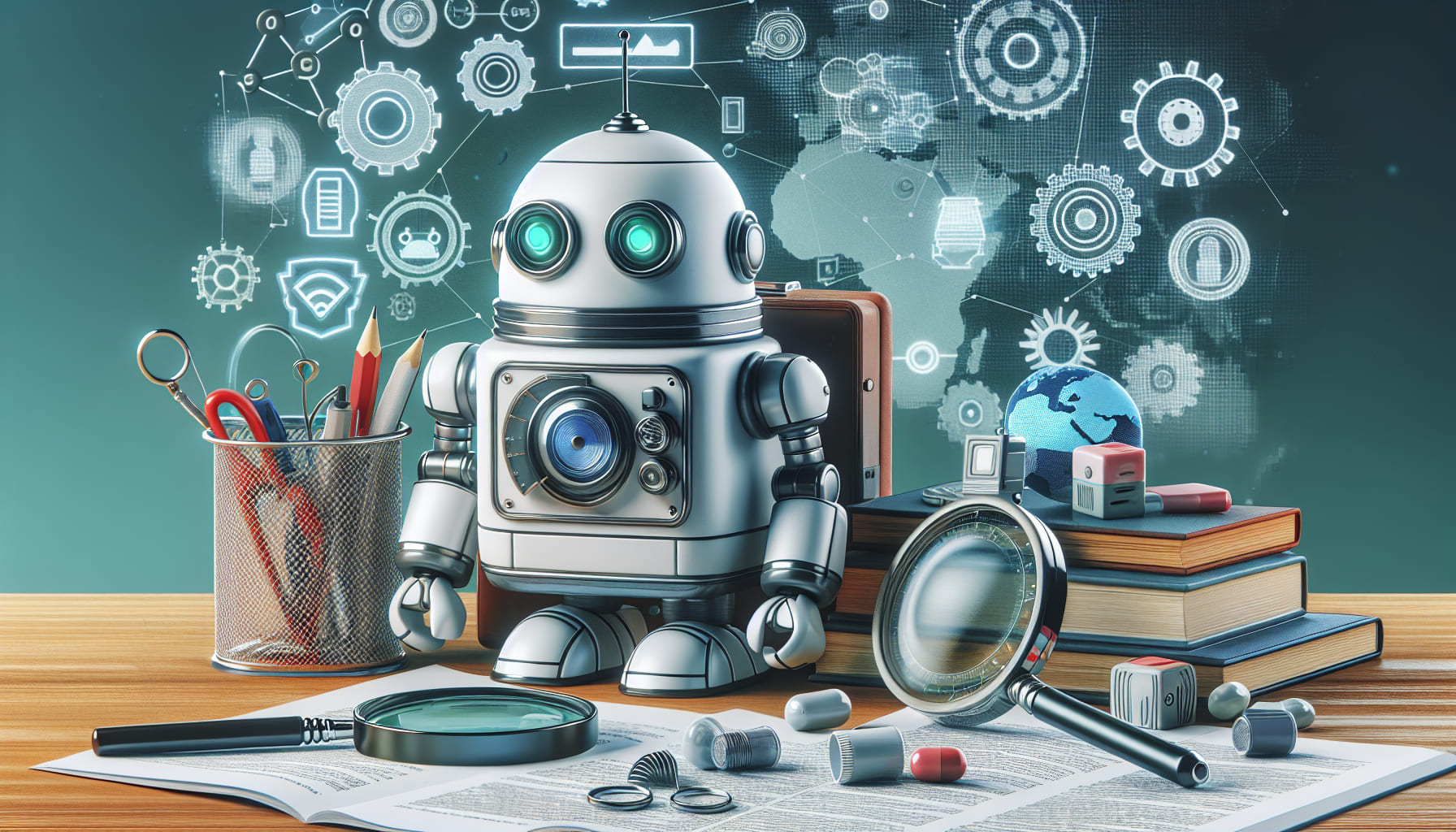

מיתוס #2: Googlebot יכול לעבד ולהבין כל סוג של תוכן בדיוק כמו דפדפן מודרני ואדם.

- המציאות: גוגל עשתה כברת דרך משמעותית ביכולות הרינדור (Rendering) והבנת התוכן. Googlebot המודרני (Googlebot Smartphone, למשל) יכול להריץ קוד JavaScript ולהבין במידה רבה את מה שנוצר דינמית על ידי JS. אולם, היכולת הזו אינה מושלמת. קוד JS מורכב מדי, שגיאות בקוד, או תהליכי טעינת תוכן אסינכרוניים ללא גיבוי מתאים (כמו Server-Side Rendering או Pre-rendering) – עלולים לגרום לכך שתוכן קריטי, כותרות חשובות או קישורים פנימיים שנבנים על ידי JS לא ייראו או יובנו כהלכה על ידי Googlebot. בנוסף, למרות שיכולת זיהוי טקסט בתמונות השתפרה, היא אינה מושלמת, וגוגל עדיין מתקשה להבין לעומק תוכן ויזואלי או אודיו ללא תמלילים, מטא-דאטה מפורטת, או סימון סכימה (Schema Markup) רלוונטי.

- ההשלכה על קידום אתרים: תוכן קריטי עלול לא להיות מאונדקס, קישורים חשובים עלולים לא להיעבר, ורלוונטיות האתר עלולה להיפגע – גם אם התוכן נראה מצוין למשתמשים אנושיים.

- המסקנה האסטרטגית: ודא שתוכן קריטי וקישורים פנימיים חיוניים זמינים ב-HTML הראשוני של העמוד, לפני שה-JavaScript רץ. אם האתר מסתמך heavily על JS, שקול יישום SSR, Pre-rendering או Dynamic Rendering. השתמש תמיד בטקסט "אמיתי" ולא בטקסט חלק מתמונות להעברת מסרים חשובים. הוסף Alt Text משמעותי לתמונות וספק תמלילים לוידאו/אודיו.

-

מיתוס #3: Googlebot מבקר בכל אתר בתדירות זהה ומתייחס לכולם שווה.

- המציאות: תדירות הזחילה (Crawl Rate) ועומק הזחילה (Crawl Depth) של Googlebot משתנים מאוד מאתר לאתר. גוגל מתעדפת סריקה על בסיס מספר גורמים מרכזיים: סמכות האתר ופופולריותו (הרבה קישורים איכותיים), תדירות עדכון התוכן (אתרים שמתעדכנים לעיתים קרובות נסרקים יותר), גודל האתר, ביצועים טכניים (אתרים מהירים וזמינים נסרקים בקלות רבה יותר), ואיכות התוכן. אתרים "חזקים" ועדכניים נסרקים בתדירות גבוהה יותר מאתרים קטנים או כאלו שמתעדכנים לעיתים רחוקות.

- ההשלכה על קידום אתרים: לוקח יותר זמן לגוגל לגלות שינויים (תוכן חדש, תיקונים) באתרים שנסרקים בתדירות נמוכה. זה מאט את תהליך האינדוקס וההשפעה של אופטימיזציות.

- המסקנה האסטרטגית: התמקד בבניית אתר איכותי בכל המובנים (תוכן, טכני, קישורים נכנסים) כדי "להרוויח" Crawl Rate גבוה יותר. פרסם תוכן חדש ועדכן תוכן קיים באופן עקבי. ודא שהאתר מהיר וזמין 100%.

-

מיתוס #4: אין לכם כל שליטה על איך Googlebot רואה או מתייחס לאתר שלכם.

- המציאות: בעוד שאינכם שולטים באלגוריתם הדירוג של גוגל, יש לכם סט כלים משמעותי שנועד בדיוק כדי להנחות את Googlebot וכיצד הוא אמור להתייחס לעמודים שונים באתר:

- קובץ robots.txt: מאפשר לכם להורות ל-Googlebot (וזחלנים אחרים) אילו אזורים באתר לא לזחול (למשל, דפי לוגין, אזורים אישיים).

- תגיות מטא robots (

noindex,nofollow): מאפשרות לכם להורות לגוגל לא לאנדקס עמוד ספציפי (אם אינכם רוצים שיופיע בתוצאות החיפוש) ו/או לא לעקוב אחרי הקישורים באותו עמוד. - מפת אתר XML (XML Sitemap): מספקת ל-Googlebot "מפה" של כל העמודים הרלוונטיים באתר שברצונכם שיזחל ויאנדקס, ומאפשרת לסמן עמודים בעלי עדיפות גבוהה יותר.

- Google Search Console: כלים כמו בדיקת URL (URL Inspection) מראים לכם בדיוק איך Googlebot ראה עמוד מסוים. ניתן לבקש מ-GSC לבצע זחילה ואינדוקס מחדש לעמודים ספציפיים לאחר שבוצעו בהם שינויים.

- ההשלכה על קידום אתרים: שימוש מושכל בכלים אלו חיוני לניהול נכון של תקציב הזחילה, מניעת אינדוקס של עמודים לא רצויים, והבטחת שהעמודים החשובים אכן נזחלים ומאונדקסים. שימוש שגוי עלול, כפי שראינו במאמר קודם על חסימת Googlebot, לחסום עמודים חיוניים בשוגג.

- המסקנה האסטרטגית: הכירו לעומק את הכלים הללו. השתמשו בהם באופן אסטרטגי ומבוקר כחלק מניהול קידום האתרים הטכני.

- המציאות: בעוד שאינכם שולטים באלגוריתם הדירוג של גוגל, יש לכם סט כלים משמעותי שנועד בדיוק כדי להנחות את Googlebot וכיצד הוא אמור להתייחס לעמודים שונים באתר:

-

מיתוס #5: כל מטרת קידום האתרים היא למצוא חן בעיני Googlebot בלבד.

- המציאות: זהו המיתוס המסוכן והנפוץ ביותר, והוא מוביל לפרקטיקות מיושנות ולא יעילות. מטרת גוגל היא לספק את התוצאות הטובות ביותר עבור המשתמש המחפש מידע, שירות או מוצר. Googlebot הוא רק האמצעי הטכני לאיסוף מידע על האתרים כדי שגוגל תוכל לשפוט את איכותם ורלוונטיותם. האלגוריתמים המודרניים שמים דגש עצום על חווית המשתמש (UX) בפועל – מהירות טעינה (Core Web Vitals), התאמה למובייל, קלות ניווט, קריאות התוכן, עומק המידע, אמינות המותג (E-E-A-T), ואיך משתמשים באמת מקיימים אינטראקציה עם האתר (זמן שהייה, שיעור נטישה, שיעור הקלקה בתוצאות חיפוש). אתרים שמנסים לרמות את Googlebot בטקטיקות "שחורות" (Black Hat SEO) כמו טקסט נסתר, דחיסת מילות מפתח מוגזמת – נענשים.

- ההשלכה על קידום אתרים: התמקדות בטכניקות שמטרתן רק למצוא חן בעיני Googlebot תוך התעלמות מהמשתמש – תוביל לדירוגים נמוכים או זמניים, ופגיעה ארוכת טווח באמון המותג.

- המסקנה האסטרטגית: קידום אתרים אמיתי הוא בניית אתר מצוין עבור משתמשים. אופטימיזציה טכנית ל-Googlebot היא רק היסוד לוודא שגוגל יכול לראות ולהבין את הערך שאתם יוצרים עבור המשתמשים. ההתמקדות העיקרית צריכה להיות בתוכן איכותי, חווית משתמש מצוינת, ואמינות.

-

מיתוס #6: Googlebot לא אוהב אתרים עם הרבה תוכן או עמודים רבים.

- המציאות: גוגל אוהבת תוכן – כל עוד הוא איכותי, רלוונטי, מקיף, ובעל ערך אמיתי למשתמשים. אתרים גדולים ומלאים בתוכן איכותי יכולים לבסס את עצמם כסמכות בתחומם (Authority), לכסות טווח רחב של נושאים וביטויים, ולענות על מגוון שאלות וצורכי משתמשים. כפי שצוין במקור, מחקרים (כמו זה של HubSpot) מראים שאתרים עם יותר עמודים איכותיים נוטים לדרג גבוה יותר. המפתח הוא לא בכמות, אלא בערך, באיכות, ובארגון התוכן.

- ההשלכה על קידום אתרים: פחד מיצירת תוכן מעמיק או עמודים רבים מונע מיצירת סמכות, כיסוי נושאי רחב, ויכולת לדרג עבור מגוון ביטויים.

- המסקנה האסטרטגית: בנה אסטרטגיית תוכן מקיפה המבוססת על מחקר מילות מפתח והבנת צורכי המשתמשים. צור תוכן מעמיק (Cornerstone Content) ועמודים רבים ואיכותיים המכסים את הנישה שלך באופן יסודי. ודא שהתוכן מאורגן היטב (מבנה היררכי, קישור פנימי).

-

מיתוס #7: Googlebot שונא דפי נחיתה (Landing Pages).

- המציאות: Googlebot אינו "שונא" דפי נחיתה. הבעיה היא דפי נחיתה "דלילים" (Thin Content) – כאלו שנוצרו רק למטרת קידום ביטוי ספציפי אך חסרים תוכן מהותי, מקורי, ובעל ערך למשתמש. דפים כאלו אכן עלולים להיפגע בדירוג. עם זאת, דפי נחיתה שנבנו היטב, בעלי תוכן רלוונטי ומספק, קריאה לפעולה ברורה, וחווית משתמש טובה – יכולים לדרג מצוין עבור מילות מפתח ממוקדות (במיוחד אלו עם כוונת המרה גבוהה) ולהיות כלי קידום אתרים ומכירות רב עוצמה, גם אם הם קצרים יותר מעמודי בלוג מקיפים.

- ההשלכה על קידום אתרים: הימנעות משימוש בדפי נחיתה אפקטיביים מפספסת הזדמנויות המרה. בניית דפים דלילים מובילה לפגיעה בדירוג.

- המסקנה האסטרטגית: בנה דפי נחיתה איכותיים וממירים, המותאמים לכוונת החיפוש, ומספקים ערך אמיתי למשתמש, גם אם התוכן ממוקד ותמציתי.

-

מיתוס #8: Googlebot שונא "תוכן כפול" ויעניש אתכם קשות על כל חפיפה.

- המציאות: גוגל מבינה שלפעמים חפיפת תוכן היא בלתי נמנעת (למשל, תיאורים טכניים סטנדרטיים של מוצרים, תוכן שמופיע גם בגרסת הדפסה). היא גם מבינה שיש בעיות "תוכן כפול טכני" עקב כתובות URL שונות לאותו עמוד (עם/בלי www, http/https, פרמטרים). גוגל אינה "מענישה" אוטומטית על כל פיסת תוכן כפול. היא שואפת לזהות את הגרסה המקורית או הרלוונטית ביותר ולהציג רק אותה בתוצאות החיפוש, כדי לא להציג תוצאות זהות שוב ושוב. במקרים של חפיפות טכניות, זה עלול להוביל לפיצול "כוח קישור" בין הגרסאות השונות ולבלבול. ענישה קשה על תוכן כפול שמורה למקרים של העתקת תוכן זדונית (Scraping) מאתרים אחרים.

- ההשלכה על קידום אתרים: בעיות תוכן כפול טכני גורמות לאי-יעילות (בזבוז Crawl Budget, פיצול Link Equity) ועלולות לפגוע באמון ודירוג אם הן נרחבות ואינן מטופלות. העתקת תוכן מאתרים אחרים היא מסוכנת מאוד.

- המסקנה האסטרטגית: הימנע לחלוטין מהעתקת תוכן ממקורות חיצוניים. טפל בבעיות תוכן כפול טכני באמצעות הפניות 301 (Permanent Redirect) ותגיות קנוניקל (Canonical Tags) תקינות. ודא שגם במקרים של חפיפות הכרחיות (למשל, תיאורי מוצרים טכניים), קיים תוכן מקורי ובעל ערך נוסף שמבדיל את העמודים.

-

מיתוס #9: Googlebot (והאלגוריתם) יכול לקרוא את המחשבות שלכם ויודע בדיוק מה הכוונות האסטרטגיות שלכם.

- המציאות: Googlebot והאלגוריתמים של גוגל אינם קוראי מחשבות. הם מערכות מבוססות תוכנה מורכבות ביותר, המשתמשות בבינה מלאכותית, למידת מכונה, עיבוד שפה טבעית, ניתוח ישויות (Entities), והבנת הקשרים הסמנטיים כדי לפרש את התוכן, המבנה והרלוונטיות של האתר שלכם. הם מנתחים דפוסים בנתוני משתמשים אגרגטיביים כדי להבין כוונות חיפוש ומה מהווה תוצאה מספקת. הם משתפרים ללא הרף בהבנת ניואנסים.

- ההשלכה על קידום אתרים: אין טעם לנסות לרמות את המערכת בדרכים לא ישרות; האלגוריתמים מתפתחים כל הזמן כדי לזהות ולהעניש מניפולציות. במקום זאת, התמקדות ב"דיבור בשפה שגוגל מבינה" (באמצעות קוד נקי, תוכן מובנה, סימון סכימה) ובמתן ערך אמיתי למשתמש – היא הדרך היעילה והבטוחה.

- המסקנה האסטרטגית: התמקד ביצירת תוכן איכותי, מובנה היטב, ורלוונטי לכוונות חיפוש שונות. השתמש בסימון סכימה (Schema Markup) כדי לספק לגוגל הקשר נוסף על סוג התוכן שלך (מתכון, מוצר, אירוע). בנה סמכות ואמון. זהו המפתח ל"דיבור בשפה" שגוגל מעריכה.

מעבר למיתוסים: הכלים שיעזרו לכם להבין באמת את Googlebot (ואת האתר שלכם)

כדי לנווט בהצלחה בעולם קידום האתרים ולהתבסס על עובדות ולא על מיתוסים, עליכם להשתמש בכלים הנכונים:

- Google Search Console (GSC): הכלי המרכזי ביותר להבנת האינטראקציה של גוגל עם האתר שלכם. דוח כיסוי (Coverage) מראה אילו עמודים מאונדקסים ואילו לא (ולמה). דוח נתוני זחילה (Crawl Stats) מציג את פעילות Googlebot באתר שלכם (תדירות, שגיאות, קודים חוזרים). כלי בדיקת URL (URL Inspection) מאפשר לכם לראות איך גוגל רואה עמוד ספציפי (כולל קוד HTML ראשוני וקוד HTML מרונדר). דוח מפות אתר (Sitemaps) מציג את סטטוס הגשת ועיבוד מפות האתר.

- כלי זחילה (Crawlers) כמו Screaming Frog: כלים אלו סורקים את האתר שלכם מנקודת מבט דומה לזו של Googlebot ומאפשרים לזהות בעיות טכניות רבות המשפיעות על זחילה ואינדוקס (קישורים שבורים, שגיאות הפניה, בעיות קנוניקל, תגיות מטא, בעיות מבנה ועוד).

- דוחות אנליטיקס (Google Analytics): דוחות התנהגות משתמשים (זמן שהייה, שיעור נטישה, מעברים בין עמודים, שיעור המרה) מסייעים להבין האם התוכן והמבנה ש-Googlebot אמור להבין אכן מספקים חוויה חיובית למשתמשים.

- כלי בדיקת סכימה (Schema Markup Validators): לווידוא שסימון הסכימה באתר שלכם הוטמע נכון ונגיש ל-Googlebot לצורך יצירת תוצאות עשירות (Rich Results).

- כלי מהירות (PageSpeed Insights, Lighthouse): למדידת Core Web Vitals והבנה האם בעיות מהירות עשויות להפריע ל-Googlebot ולחווית המשתמש.

סיכום: לא למצוא חן בעיני הבוט, אלא לבנות אתר מצוין שרובוטים ומשתמשים אוהבים

ההבנה של Googlebot – הפונקציונליות שלו, המגבלות שלו, והאופן שבו הוא מקיים אינטראקציה עם אתרים – היא ללא ספק מרכיב חיוני בכל אסטרטגיית קידום אתרים מוצלחת. היא מאפשרת לנו לדבר ב"שפה" שגוגל מבינה, לטפל בבעיות טכניות המשפיעות על נראות, ולהנחות את הבוט ליעדים הנכונים.

אבל חשוב לא פחות להפריך את המיתוסים הנפוצים ולא ליפול למלכודות של תפיסות שגויות. Googlebot אינו קוסם, הוא פועל לפי כללים ותקציבים, ומטרת הדירוג בסופו של דבר היא לשרת את המשתמש. התמקדות בטכניקות שמטרתן רק לרמות או להרשים את הבוט, תוך התעלמות מאיכות התוכן וחווית המשתמש, היא מתכון בטוח לכישלון בטווח הארוך.

הצלחה אמיתית בקידום אתרים מגיעה משילוב של הבנה טכנית מעמיקה של Googlebot והאלגוריתם, יחד עם התמקדות בלתי מתפשרת ביצירת אתר שמועיל, רלוונטי, ובעל חווית משתמש מצוינת עבור אנשים. על ידי התבססות על עובדות, שימוש בכלים הנכונים כדי להבין את האתר שלכם באמת, ובניית אסטרטגיה שחושבת קודם כל על המשתמש – אתם לא רק מאפשרים ל-Googlebot לזחול ולהבין את האתר ביעילות, אלא גם מספקים לגוגל בדיוק את מה שהיא מחפשת להציג למשתמשים שלה.

אל תבזבזו זמן על מיתוסים ו"טריקים" קצרי טווח. התמקדו בבניית אתר באמת נהדר, תוך הבנה אמיתית של האופן שבו Googlebot והאלגוריתם עובדים במציאות – זוהי הדרך האמיתית לכבוש את צמרת תוצאות החיפוש ולהשאיר חותם דיגיטלי משמעותי. המשימה הסודית שלכם אינה לחשוף סודות אפלים, אלא ליישם את הידע הזה כדי לבנות את האתר הטוב ביותר האפשרי.